2025-09-01作者:大湾区国际数据中心大会暨展览会

摘要:文章深入探讨应用于数据中心、智算中心的液冷系统在不同使用场景下,配合不同冷却系统的节能性、应用效果及限制条件,对比分析常见风冷系统、常规冷板式液冷系统及浸没式液冷系统的架构、节能效果,探讨高温服务器的应用,为新建数据中心、改造数据中心提供理论依据与指导。研究显示,液冷系统与不同冷却系统搭配,可提高原冷却系统自然冷源利用时间20%~30%,降低数据中心PUE0.05~0.06,具有明显节能优势。

在“双碳”宏观形势下,政府部门对数据中心PUE(电能利用效率)监管日益趋严,近年来国家、行业层面对数据中心建设提出更高要求,促进数据中心集约化、规模化、绿色化发展,对不同类型或区域数据中心要求PUE低于1.25、1.2或1.15;同时对机架平均利用率、算力规模、高性能算力占比等均作出明确要求;“鼓励应用高密度集成等高效IT设备、液冷等高效制冷系统”及“推动数据中心采用液冷、机柜模块化、余热回收利用等节能技术模式”等是现阶段数据中心、智算中心重点发展方向。

数据的高速增长带来AI模型的规模和复杂性不断增加,到2030年,全球AI算力需求将增长近390倍,算力需求远超摩尔定律。我国智能算力增长迅速,2021年规模已达到104EFLOPS,占比超过总算力50%,预计2030年将升至70%,成为算力快速增长的主要驱动力。算力的激增,带来AI芯片TDP持续增加,根据赛迪顾问预测,2025年全球数据中心单机柜平均功率有望达到25kW。现阶段芯片在性能提升的同时,芯片功耗也大幅提高,CPU的设计功耗(TDP)已达到300W,GPU则达到500W,未来芯片平均每年提升20%的算力和功耗。2024年3月,NVIDIA发布的最新AI芯片B200,其TDP超过1000W;2024年5月,Intel透露其下一代AI加速卡功耗将达到史无前例的1500W。

算力的快速增长和芯片的性能提升将带来高密数据中心的规模出现,常规风冷模式已无法满足服务器散热需要,同时多样化算力设备并存带来机柜宽频功率需求,常规风冷技术难以满足新型数据中心高密、节能的需求,液冷技术迎来广阔的发展机遇及市场空间,液冷技术可有效解决算力基础设施散热和高能耗的痛点问题,是在算力增长背景下散热的关键技术,满足算力池化及资源池化、芯片资源供给、训推一体需灵活切换等多样化需求,有效应对新形势下数据中心、智算中心快速发展带来的芯片能耗与散热、机柜散热、水电资源绿色高效利用等机遇与挑战。

冷板式液冷与浸没式液冷是目前液冷技术中的主流,在液冷数据中心建设中,尤其冷板式液冷系统,并非单一系统的应用,需搭配其他冷却系统共同作用,文章主要探讨不同冷却系统对整体液冷系统节能性的影响。

伴随数据中心的不断发展,制冷方式和制冷形式也在不断发展变化,常见的可搭配液冷系统共同使用的冷却系统包括冷冻水系统、水侧间接蒸发冷却系统、风侧间接蒸发冷却系统,氟泵空调等。

冷冻水系统可分为风冷冷冻水空调系统和水冷冷冻水空调系统,数据中心、智算中心以水冷冷冻水空调系统为主要应用对象,由冷却塔、冷水机组、冷却水泵、冷冻水泵、空调末端等组成,具备集中部署、适配性强、初期投资低的优势,在系统控制、交付周期上略有劣势。

水侧间接蒸发冷却系统是对冷冻水系统的优化提升,由间接蒸发冷却塔、冷水机组、冷却水泵、冷冻水泵、空调末端等组成,通过间接蒸发复合直接蒸发冷却,利用空气的干湿球温度差,可获得低于室外空气湿球温度的冷却水,提高自然冷源利用能力,主要问题在于设备占地面积大,同时初期投资高于常规冷冻水系统。

风侧间接蒸发冷却系统有多个复合机械制冷的间接蒸发冷却空调机组组成,为一体化设备,通过间接蒸发冷却,对机房回风进行降温,当出风温度较高时,需采用压缩机制冷进行补充。此类系统具备较节能性强、自控程度高、交付周期短的特点,但存在占用机房空间降低装机率及投资较高等问题。

氟泵空调类系统属于风冷型空调,由室内机及室外机组成,相比风冷直膨空调增加氟泵组件,增加对自然冷源的利用,节能性相比风冷直膨空调有显著提升。氟泵空调同样属于一体化设备,易于调控,部署便捷,适用于模块化数据中心,氟泵空调节能性相比上述冷却系统则不占优势。

因冷板式液冷将冷板覆盖于服务器发热器件表面,通常不覆盖整个服务器,从而冷板式液冷散热由液冷及风冷两部分组成,相对应的,冷板式液冷冷却系统包含风冷冷却和液冷冷却两套系统。以上冷却系统均可用于解决冷板式液冷风冷部分散热,液冷部分散热由冷却塔、冷量分配单元、液冷机柜、液冷服务器构成。

浸没式液冷无需额外配置风冷冷却系统,其冷却系统与冷板式液冷中液冷部分散热系统组成相同,浸没式液冷在冷源建设上相对简化,但其本身形态、配置变化较大,应用时需着重解决服务器、数据中心的兼容适配问题。

不同冷却系统具有不同的节能效果,对自然冷源的利用能力是重要因素之一。

在采用水冷冷冻水系统及水侧蒸发冷却系统的数据中心设计中,机房内送风温度通常在24~27℃,冷冻水系统常见的送回水设计工况为15℃/21℃、18℃/24℃、22℃/28℃,提高送回水温度可提升自然冷源利用时间。

自然冷源利用时长计算,基于开式冷却塔,考虑扣除板式换热器温差及冷却塔冷幅高,最终可利用自然冷源的温度为:

T=Ts-ΔT1-ΔT2 (1)

式(1)中:T为自然冷源利用起始温度(℃);Ts为冷冻水供水温度(℃);ΔT1为板式换热器温差,取1.5℃;ΔT2为冷却塔冷幅高,对于水冷冷冻水系统中的开式冷却塔,冷幅高取3℃。

以送回水温度15℃/21℃为例,自然冷源利用起始温度为10.5℃,则当室外环境湿球温度低于10.5℃时可完全利用自然冷源;送回水温度18℃/24℃时,室外湿球温度低于13.5℃时可完全利用自然冷源;22℃/28℃送回水温度对应的可完全利用自然冷源湿球温度为17.5℃。

对于水侧间接蒸发冷却系统,可获得低于室外环境湿球温度的冷却水,一般在西北干燥地区(计算湿球温度低于23℃地区),可低于室外湿球温度3℃甚至4℃;在计算湿球温度大于23℃,小于27℃地区,出水温度可低于室外湿球温度2~3℃;在计算湿球温度大于27℃地区,出水温度可低于室外湿球温度1.5~2℃。该次计算中取-1.5℃作为水侧间接蒸发冷却系统冷幅高。

则对于水侧间接蒸发冷却系统,板式换热器温差与冷却塔冷幅高互补,当室外湿球温度分别低于15℃/18℃/22℃时,可完全利用自然冷源。

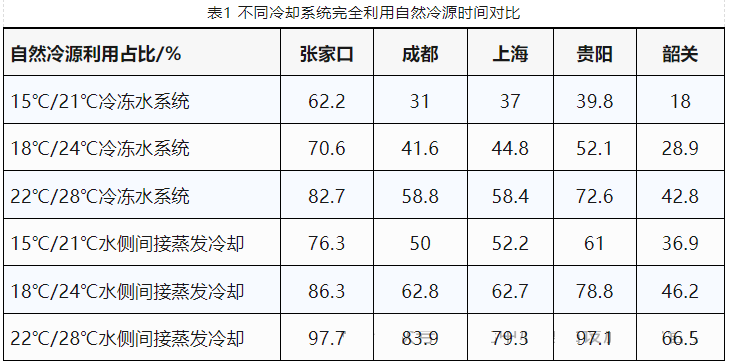

结合国家八大枢纽节点,选取张家口,成都,上海,贵阳及韶关作为对比城市,根据各地逐时气象参数,统计全年满足完全利用自然冷源的湿球温度小时数,计算其完全利用自然冷源的时长及在全年中占比,如表1所示。

不同城市因地理位置及气候条件不同,可利用自然冷源时长不同,在相同城市,提高供回水温度及利用间接蒸发冷却后,可延长自然冷源利用的效果。

对于冷板式液冷数据中心,液冷部分的散热具有较高的换热温度,与服务器连通的二次侧液体供回液温度通常为40℃/50℃,为二次侧散热的一次侧液体温度通常为35℃/45℃,该温度下在全国范围内,基本可实现全年利用自然冷源。

冷板式液冷数据中心风液散热占比与服务器架构、服务器类型有关,对仅含CPU的服务器,液冷占比约50%~65%;对含有CPU+MEM的服务器,液冷占比约为60%~80%;对含有CPU+GPU的服务器,液冷占比约80%~90%。液冷占比的提升,可提高自然冷源的利用率,从而提升数据中心整体的节能性。可通过如下方式计算冷板式液冷数据中心的自然冷源利用占比:

R=Rl+Ra×Rr (2)

式(2)中:R为冷板式液冷数据中心自然冷源利用占比;Rl为冷板式液冷数据中心液冷散热占比;Ra为冷板式液冷数据中心风冷散热占比;Rr为独立应用该风冷冷却系统时自然冷源利用占比。

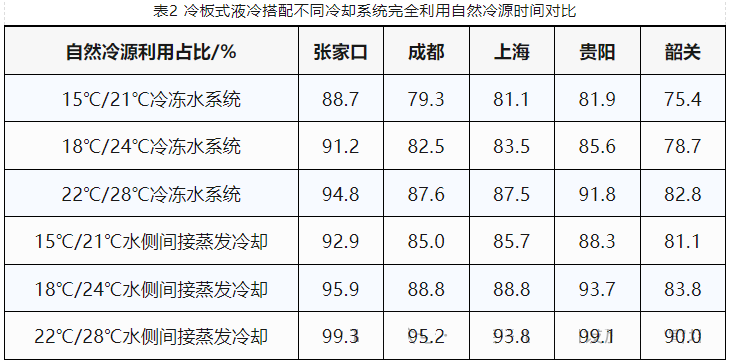

以液冷、风冷散热7∶3为例,冷板式液冷数据中心搭配不同冷却系统自然冷源利用占比见表2。

液冷系统的加入可提升自然冷源利用的占比,但提升效果不同,在气候炎热地区城市、风冷散热供回水温度设置较低的数据中心以及未采用蒸发冷却技术的数据中心,采用液冷系统对自然冷源利用占比有明显提高,可获得显著节能性收益。

冷板式液冷数据中心在自然冷源利用时长上,应分为两部分,一部分为液冷系统,可全年利用自然冷源,一部分为风冷系统,此部分利用自然冷源的小时数与独立使用该制冷系统时的自然冷源利用小时数相同。

氟泵空调、风侧间接蒸发冷却空调等风冷型空调,对自然冷源的利用与系统控制策略有关,满足系统切换条件时,系统将利用自然冷源运行。如氟泵空调在室外干球温度5℃以下时,切换氟泵运行模式利用自然冷源;风侧间接蒸发冷却空调在干球温度小于等于16℃时运行干模式,干球温度大于16℃、湿球温度小于等于18℃时运行湿模式,干球温度大于16℃、湿球温度大于18℃运行混合模式,干模式、湿模式均为自然冷源利用模式。温度切换点可根据实际应用场景调整。

这两类系统的能效、运行频率等参数同样对节能性有重要影响,不能仅依靠室外温度及自然冷源判断。

冷板式液冷系统与氟泵空调、风侧间接蒸发冷却空调的结合,对数据中心节能性的影响与水冷冷冻水系统及水侧蒸发冷却系统相似。

浸没式液冷系统无需配套其他冷却系统运行,可认为其不受外部环境影响,在各地均可实现全年利用自然冷源,具有很高的节能性。

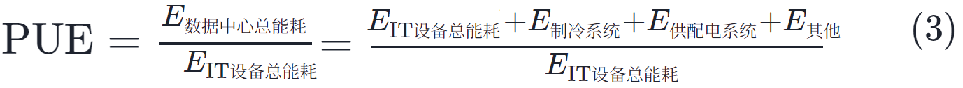

电能利用效率(PUE)是评价数据中心节能性的重要指标,计算方法为:

该计算中,根据逐时气象参数详细计算不同冷却系统的PUE因子,冷冻水系统及水侧间接蒸发冷却系统按照完全自然冷却、部分自然冷却及机械制冷3种模式确定冷水机组启用时间,利用环境湿球温度,考虑冷却塔、冷冻水泵、冷却水泵等系统内能耗,计算相应全年PUE因子;氟泵空调分为氟泵模式、压缩机模式及混合模式,综合考虑气象条件干球温度及系统COP值计算全年PUE因子;风侧间接蒸发冷却空调按干模式、湿模式及混合模式,综合干球温度、湿球温度确定运行模式及系统能耗,计算全年PUE因子。

供配电系统的PUE因子按照一路市电和一路高压直流系统预估,取值0.055;其他能耗的PUE因子取值0.012。

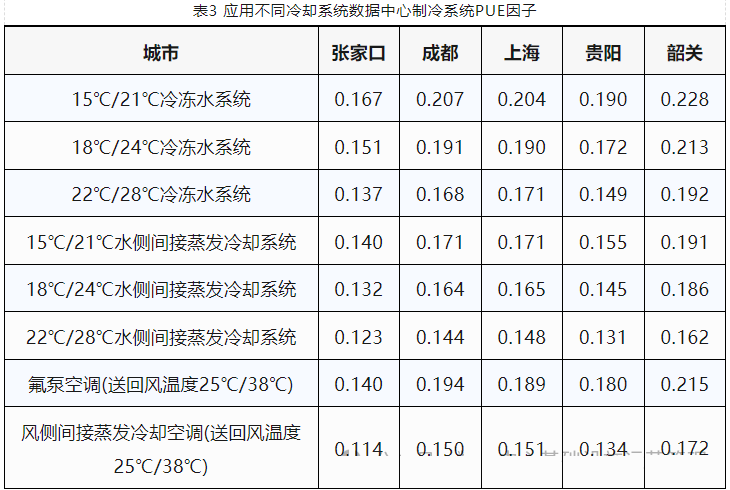

以张家口、成都、上海、贵阳及韶关为例,计算应用不同冷却系统的数据中心PUE值,见表4。

PUE的计算与系统类型、系统内设备选型、运行模式控制等相关,本组计算数据仅供参考。

水冷冷冻水系统及水侧蒸发冷却系统PUE变化趋势与自然冷源利用时间相关,自然冷源时间长可降低数据中心PUE。同时间接蒸发技术的利用在水冷型系统和风冷型系统中均具有明显节能优势,降低PUE值。

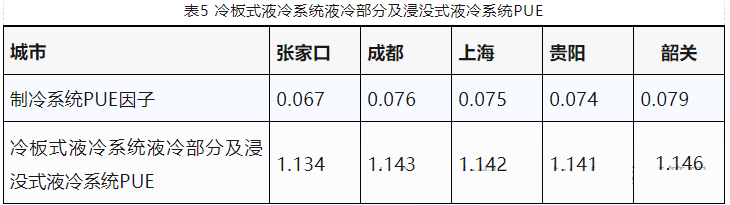

对于冷板式液冷数据中心中的液冷散热部分及浸没式液冷数据中心,可认为在全年采用自然冷源冷却,且二者冷却系统设备类型基本一致,均为冷却塔、冷量分配单元CDU及相应水泵,可近似认为二者PUE值相同(表5)。

整体冷板式液冷数据中心的PUE计算涉及风液两部分系统及其比例,计算方法如下:

PUE=Rl×PUEl+Ra×PUEa (4)

式(4)中:PUE为冷板式液冷数据中心整体全年PUE;Rl为冷板式液冷数据中心液冷散热占比;PUEl为液冷系统液冷部分PUE;Ra为冷板式液冷数据中心风冷散热占比;PUEa为液冷系统风冷部分PUE。

考虑冷板式液冷数据中心7∶3的液冷及风冷散热比例,则搭配不同冷却系统的冷板式液冷数据中心PUE值:

根据计算结果应用冷板式液冷的数据中心或智算中心,可有效降低PUE至1.2以下,部分区域、部分技术可满足PUE低于1.15(表6)。通过对制冷系统、供配电系统等优化,可进一步扩大低PUE范围。浸没式液冷普遍可实现PUE低于1.15。总体来看,液冷技术具备较高的节能性,有望成为未来数据中心及智算中心的核心制冷技术。

增加自然冷源利用时长是提高数据中心节能性的有效途径,如可以提高系统送回水温度或运行模式切换温度,则可实现提升自然冷源的利用时长,切换温度的设置受到机房环境温度的限制,而机房环境温度设置需满足服务器的散热需求,从根本上讲,为满足服务器的散热要求,现行机房环境温度普遍设置为24~27℃,从而限制了自然冷源的利用时长。

对于风冷数据中心及冷板式液冷数据中心,有必要探索应用高温服务器、高温机房的模式,提高机房内环境温度,从而提升自然冷源利用比例,获取最佳的节能效果。

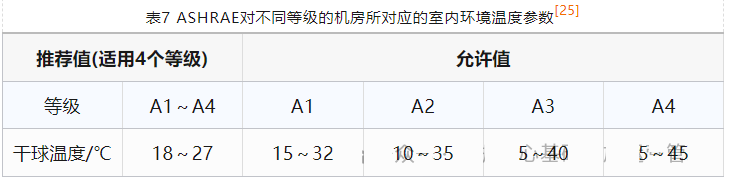

美国ASHRAE(美国采暖、制冷与空调工程师学会)在2004年发布它的第一版数据中心热环境导则,当时对数据中心的温度范围推荐值为20~25℃。这是一个非常保守的温度值,是基于数据中心的可靠性,把机房的可靠性及无故障运行时间要求放在首位,其次才考虑数据中心的节能。之后在2011年ASHRAE把这个温度范围推荐值扩大到18~27℃,允许值变为5~45℃,这为自然冷却等新的节能技术创造了条件。

推荐值与允许值:指的是进入电子设备的空气状态,即进风状态(表7)。设备长时间在推荐值范围之外运行,尤其运行在接近允许运行环境的极端值时,可能导致设备可靠性降低和寿命缩短,允许值是一个非常接近于IT设备制造商的用户文档规定的温度限制,可以认为在短暂的时间内,设备可以在允许值温度范围内运行,但对于“短暂时间”没有量化数据。

数据中心通常适用于A1及A2等级。

国内依据GB 50174—2017《数据中心设计规范》,当IT设备生产企业有明确温度使用要求时,按照IT设备参数执行,若未确定设备参数时,按照冷通道送风温度18~27℃执行。对机房环境温度有严格限制。

机房环境温度的提高对服务器有三方面的影响,一是对服务器可靠性的影响,二是对服务器性能的影响,三是对服务器运行功率的影响,前两个问题应在服务器设计阶段解决,提升服务器长期稳定运行温度及耐受温度至35℃以上,并不降低故障率及CPU、GPU、内存、硬盘等零部件性能,为服务器在高温机房应用创造条件;后一个问题可优化服务器运行逻辑,自适应匹配风扇转速及能耗,综合考虑自然冷源的利用判断最终节能效果。

液冷系统与不同冷却系统搭配,根据应用条件不同,普遍可提高原冷却系统自然冷源利用时间20%~30%,降低数据中心PUE0.05~0.06,有明显节能效果,少数地区及应用条件下可提高自然冷源利用时间50%以上,降低PUE0.1以上。

水冷冷冻水系统、水侧间接蒸发冷却系统与液冷系统具备相似的设备配置,可考虑采用模块化建设模式,实现风冷散热与液冷散热模块的互换,增强液冷技术在应用初期的灵活性及适配性;同时可探索高温机房、高温服务器在冷板式液冷数据中心的应用,促进风液融合。

@大湾区国际数据中心大会暨展览会 版权所有